『問題解決型』ハードウェアメーカー

ファナティック

-

- ファナティックの特長 ファナティックの特長

- /

- 製品&ソリューション 製品&ソリューション

- /

- 導入事例 導入事例

- /

- 最新ニュース 最新ニュース

- /

- ファナティックレポート ファナティックレポート

- /

- サポート サポート

- /

- 会社案内 会社案内

- /

- 採用情報 採用情報

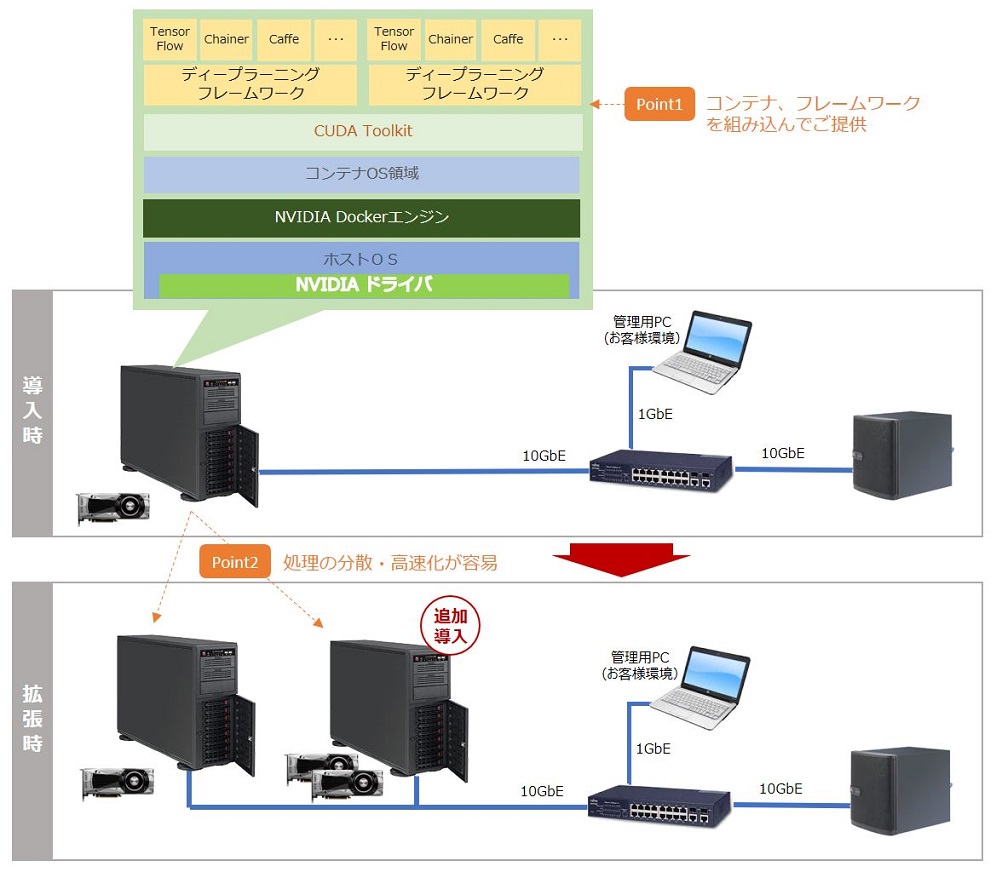

ディープラーニング向けのフレームワークとして数多くのソフトが登場しています。研究者の間で広く使われる米California大学が提供する「Caffe」やカナダのMontreal大学の「Theano/Pylearn2」のほか、Preferred Networksが開発したニューラルネットワークを実装するためのライブラリである「Chainer」、 米Googleの「TensorFlow」など、これらディープラーニング系のフレームワークをコンテナ上にあらかじめ実装。必要最低限かつ最適なスペックのハードウェアに組み込んだ状態でお届けいたします。

実際にさまざまな学習用データが蓄積されて効果が得られ、さらに学習スピードをあげる必要に迫られた場合には演算用マシンを、データが増えてきた際には追加の保存先を用意しなればなりません。演算ノード、ストレージ、いずれもすでに構築されたシステムに追加するだけで、いつでも手軽にシステムの拡張が可能です。

演算ノード、スイッチ、ストレージ、これら3つの機能がすでに稼働しており、検証済のシステムの追加導入となりますので、機器検討や導入までの手続きといったプロセスがまるごと不要となり、また初期導入時同様ライブラリやフレームワークのセットアップも不要です。

・ディープラーニングにおける画像を使った機械学習

・同一マシン上に複数環境を構築、処理

| CPU | メモリー | ストレージ |

|---|---|---|

| Intel® Xeon®スケーラブル・プロセッサー 2基搭載 | 標準128GB 最大1536GB DDR4 2666MHz ECC RDIMM | 1TB SATA3 HDD x 1 |

| CPU | メモリー | ストレージ |

|---|---|---|

| 第2世代Intel® Xeon®スケーラブル・プロセッサー2基搭載 | 標準96GB 最大1.5TB DDR4 2933MHz ECC RDIMM | 960GB SATA3 SSD x 2/6.4TB NVMe SSD x 2 |