『問題解決型』ハードウェアメーカー

ファナティック

-

- ファナティックの特長 ファナティックの特長

- /

- 製品&ソリューション 製品&ソリューション

- /

- 導入事例 導入事例

- /

- 最新ニュース 最新ニュース

- /

- ファナティックレポート ファナティックレポート

- /

- サポート サポート

- /

- 会社案内 会社案内

- /

- 採用情報 採用情報

用途に合わせた最適構成で実現する

社内業務の効率化や高度化を図るための生成AIの活用が加速しています。特にクラウドベースのAIサービスは、業種や業務に特化するなど多様化も進んでいますが、以下のような課題も見えてきました。

こうした背景から、いま多くの企業が注目しているのが、社内サーバーやワークステーションで実行するローカルLLM(オンプレミス大規模言語モデル)であり、LLaMA、Mistral、Gemmaといったオープンなモデルを活用したセキュアかつ高自由度なAI環境の構築です。

ローカルLLMは、多様な業務シーンでの活用が期待されています。現在、代表的な用途として以下が注目されています。

社内規定や技術文書、業務マニュアルなどの文書データをAIが理解し、検索や要約、質問に対する回答に活用。

お客様からのお問い合わせ履歴をもとに、対応案を自動生成。有人対応の効率化や品質の標準化や均一化に貢献。

ソースコードを解析し改善案やテンプレートコードを提案。開発業務の効率化と工数を削減。

製品紹介文やプレスリリースの草案をAIが生成。時間短縮とクリエイティブ強化を両立。

業界用語や企業独自の用語に対応した、社内専用AIアシスタントの開発にも対応可能。

冒頭紹介したクラウドベースのAIサービスに対し、

ローカルLLMにはセキュリティ、低コスト運用、カスタマイズ性、処理スピードにおけるメリットが期待されています。

クラウドを介さず、社内環境内で完結するため、機密情報を含む処理も安心して行えます。

API課金が不要なため、使えば使うほどコストメリットが大きくなります。

業務に合わせた軽量化や精度調整、UI連携も可能。自社仕様に最適化されたAI運用が実現します。

通信の遅延がないため、リアルタイム処理にも強み。UXの向上にもつながります。

高い計算リソースが必要となるLLMの実行環境にはGPUを搭載した高性能なハードウェアが欠かせません。

とくにGPUの計算性能、VRAM容量や帯域幅、消費電力などはハードウェア構成要件として重要なポイントです。

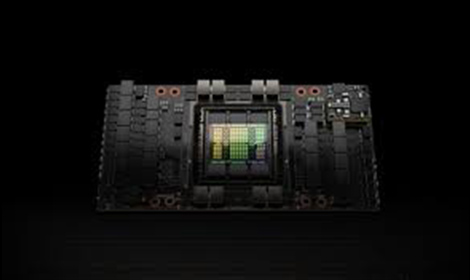

次世代のGPUアーキテクチャ「Blackwell」を採用した高性能GPUです。192GBのHBM3eメモリーを搭載しており、大規模なAIモデルのトレーニングや推論に必要な高い演算能力を提供します。また、複数のGPUの接続を第5世代のNVIDIA NVLink™で行い、高速なデータ転送を実現します。

| CPU | インテル® Xeon® 6 プロセッサー 2基搭載 |

|---|---|

| メモリー | 2304GB DDR5 ECC RDIMM (96GBx24) |

| GPU | NVIDIA B200 180GB SXM5 x8 (計1440GB) |

| ストレージ | 1.9TB NVMe SSD M.2 x2/3.84TB NVMe SSD PCIe Gen5 U.3 x8 |

| ネットワーク | NVIDIA® ConnectX®-7 400GbE / NDR IB Single-port OSFP x2 |

| 電源 | 200V 5250W x6 (3+3) 冗長電源(80PLUS Titanium認証) |

| サイズ | 449(W) x 843.28(D) x 438.8(H)mm |

96GBの超高速GDDR7メモリー、第5世代Tensorコア、第4世代RTコアを搭載した RTX PRO 6000シリーズは、エージェント型AI、フィジカルAI、科学計算からフォトリアルなレンダリング、3Dグラフィックス、リアルタイムビデオ処理まで、AI とクリエイティブワークロードの全範囲を加速します。

| CPU | AMD EPYC™ 9005シリーズ・プロセッサー(第5世代)2基搭載 |

|---|---|

| メモリー | 1536GB DDR5 ECC RDIMM (64GBx24) |

| GPU | NVIDIA RTX PRO 6000 Blackwell Server Edition x8 (計768GB) |

| ストレージ | 3.8TB 2.5" NVMe SSD x 2 |

| ネットワーク | 10GbE 2ポート(RJ45) |

| 電源 | 1800W x4(2+2) 冗長電源(80PLUS Titanium認証) |

| サイズ | 437(W) x 737(D) x 178(H)mm |

| CPU | インテル® Xeon® 6 プロセッサー 1基搭載 |

|---|---|

| メモリー | 512GB DDR5 ECC RDIMM (64GBx8) |

| GPU | NVIDIA RTX PRO 6000 Blackwell Server Edition x2 (計192GB) |

| ストレージ | 1.9TB 2.5" NVMe SSD x 2 |

| ネットワーク | 10GbE 2ポート(RJ45) |

| 電源 | 1300W 100V シングル電源 |

| サイズ | 438(W) x 500(D) x 176(H)mm |

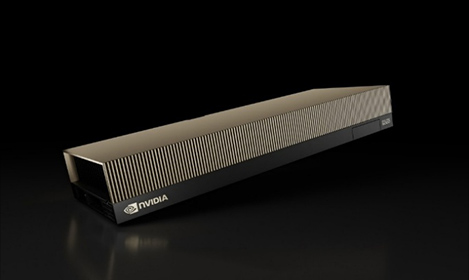

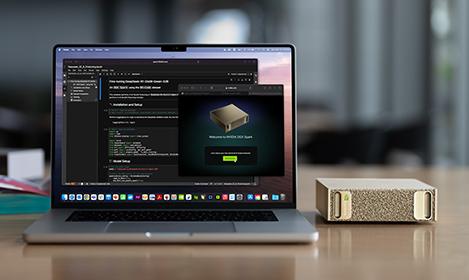

電力効率が高いコンパクトなフォームファクターで、1000 AI TOPSのAIパフォーマンスを実現。プリインストール済みのNVIDIA AIソフトウェアスタックと128GBのメモリにより、本番環境を構築する前段階のスモールモデルでのPoCおよびテスト環境としてローカルでプロトタイピングや推論を行えます。

なお、ASUS社のASUS Ascent GX10のご提案もできますのでぜひお気軽にお問い合わせください。

ファナティックはGPUサーバーの業界のリーダーとして、企業や大学・研究機関向けにお客様の課題を解決するオーダーメイド製品を20年以上に渡って提供し続けています。

NPN(NVIDIAパートナーネットワーク)メンバーとしての強固なパートナーシップを活かし、早い段階での新製品の検証を行うことでお客様の製品選定の時間や工数削減に貢献するとともに、ネットワーク機器やストレージ、ラックなども含めたトータルでのご提案が可能です。

出荷製品の詳細な記録によるトレーサビリティ、24時間365日オンサイト、センドバックの保守体制で充実したサポート体制で導入から運用までをバックアップします。

NVIDIA H100 NVL または NVIDIA RTX™ 6000 AdaなどハイエンドGPUを8基搭載可能。画像認識や自然言語処理などのワークロード用に開発された複雑かつ大規模なAIモデルの学習などに最適です。

東大阪の製造拠点であるプロダクションセンターでは、構成にもとづいた製造指図書から製造部門が組み立てと検証を行います。またここでは技術部門が前述したベンチマーク情報の取得や稼働音測定なども行っています。

これらの情報は、お客様に構成の提案を行っている営業部門にタイムリーに集められるため、製造の進捗状況はもちろん、テクニカルな情報も集約されますので、構成した製品に関する詳細かつ具体的な内容をお届けすることを可能にしています。

すぐに使える状態で納品してほしいというご要望にお応えできるよう、ファナティックではディープラーニング環境のセットアップをサポートしています。これにはエヌビディア社からリリースされる最新のツールや情報のキャッチアップが欠かせませんので、技術部門が中心となって密なコミュニケーションを図っています。

このような体制に大変重要な役割を果たしているのが、エヌビディア社のNPN(NVIDIA Partner Network)で、ファナティックはこの制度に参画することでディープラーニングの活用を、より多くのお客様にご提案しています。