『問題解決型』ハードウェアメーカー

ファナティック

-

- ファナティックの特長 ファナティックの特長

- /

- 製品&ソリューション 製品&ソリューション

- /

- 導入事例 導入事例

- /

- 最新ニュース 最新ニュース

- /

- ファナティックレポート ファナティックレポート

- /

- サポート サポート

- /

- 会社案内 会社案内

- /

- 採用情報 採用情報

2025.01.16ニュースリリース

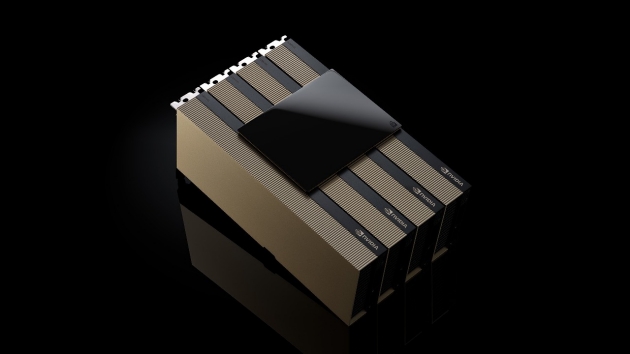

NVIDIA H200 NVL/H200 SXMの取り扱い開始について

■NVIDIA H200

進化したNVIDIA HopperアーキテクチャをベースとするNVIDIA H200は、高速かつ大容量なHBM3eメモリを提供する初のGPUです。4.8TB/sのメモリ帯域幅と141GBの大容量メモリは、H100 TensorコアGPUに比べて1.4倍の高速化と約2倍の大容量化が図られており、生成AIやLLMなどのアプリケーションやHPCのさらなるパフォーマンスの向上を実現します。

※本製品は2025年4月以降の出荷開始を予定しております。

■ベンチマーク情報

NVIDIA® H200 vs H100 NVLベンチマーク比較~TensorFlow学習ベンチマーク(ResNet50)~

■GPUサーバーはファナティックにおまかせ下さい!

ファナティックはGPUサーバーの業界のリーダーとして、企業や大学・研究機関向けにお客様の課題を解決するオーダーメイド製品を20年以上に渡って提供し続けています。

NPN(NVIDIAパートナーネットワーク)メンバーとしての強固なパートナーシップを活かし、早い段階での新製品の検証を行うことでお客様の製品選定の時間や工数削減に貢献するとともに、ネットワーク機器やストレージ、ラックなども含めたトータルでのご提案が可能です。

出荷製品の詳細な記録によるトレーサビリティ、24時間365日オンサイト、センドバックの保守体制で充実したサポート体制で導入から運用までをバックアップします。

主な性能

| NVIDIA H200 SXM | NVIDIA H200 NVL | |

| GPUアーキテクチャ | NVIDIA Hopper Architecture |

NVIDIA Hopper Architecture |

| 倍精度浮動小数点 演算性能(FP64) |

34 TFLOPS | 30 TFLOPS |

| FP64 Tensor Core演算性能 | 67 TFLOPS | 60 TFLOPS |

| 単精度浮動小数点 演算性能(FP32) |

67 TFLOPS | 60 TFLOPS |

| TF32 Tensor Core演算性能 | 989 TFLOPS | 835 TFLOPS |

| BFLOAT16 Tensor Core演算性能 | 1,979 TFLOPS | 1,671 TFLOPS |

| FP16 Tensor Core演算性能 | 1,979 TFLOPS | 1,671 TFLOPS |

| FP8 Tensor Core演算性能 | 3,958 TFLOPS | 3,341 TFLOPS |

| INT8 Tensor Core演算性能 | 3,958 TOPS | 3,341 TOPS |

| GPUメモリ | 141GB | 141GB |

| メモリバンド幅 | 4.8TB/s | 4.8TB/s |

| デコーダー | 7 NVDEC 7 JPEG |

7 NVDEC 7 JPEG |

| 最大熱設計電力 (TDP) | 最大700W(構成可能) | 最大600W(設定可能) |

| マルチインスタンス GPU | 各18GBで最大7個のMIG | 最大7パーティション(各16.5GB) |

| フォーム ファクター | SXM | PCIeデュアルスロット空冷 |

| 相互接続 | NVIDIA NVLink:900GB/秒 PCIe Gen5:128GB/秒 |

2台または4台構成時のNVIDIA NVLink ブリッジGPU1台あたり900GB/秒 PCIe Gen5: 128GB/秒 |

※仕様などは予告なしに変更されることがあります。

※記載されている会社名、製品名は各社の商標または登録商標です。