『問題解決型』ハードウェアメーカー

ファナティック

-

- ファナティックの特長 ファナティックの特長

- /

- 製品&ソリューション 製品&ソリューション

- /

- 導入事例 導入事例

- /

- 最新ニュース 最新ニュース

- /

- ファナティックレポート ファナティックレポート

- /

- サポート サポート

- /

- 会社案内 会社案内

- /

- 採用情報 採用情報

2024.07.17お知らせ

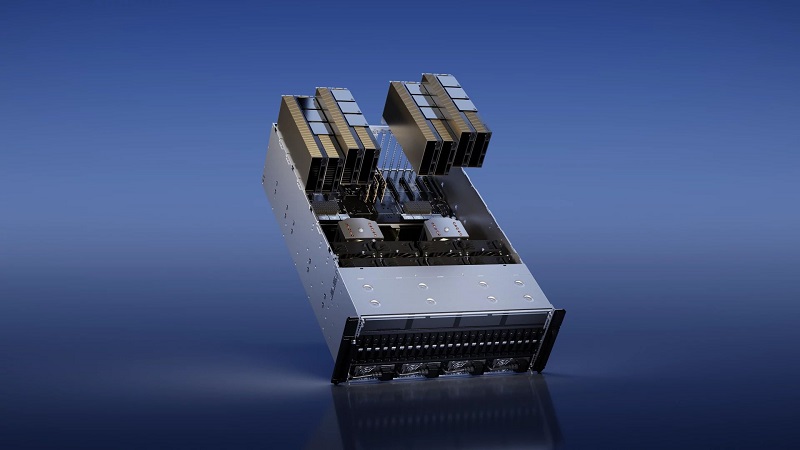

NVLinkブリッジ接続されたH100 NVLは、合計188GB HBM3メモリと7.8TB/sによって大規模言語モデル推論を加速、またHPCアプリケーションのパフォーマンスを飛躍的に向上します。今回このH100 NVLについて、学校・教育機関業様向けに特別価格キャンペーンを実施いたします。

通常価格の最大25%OFFでご提供。

数量に限りがございますのでお早目にお申込みください。(お申込みはページ下部のお問い合わせボタンからどうぞ)

■対象のお客様

・大学、大学院、短期大学、高等専門学校、専修学校、高等学校等の学校教育法で定められた教育機関のお客様

■キャンペーン期間

2024年12月末日(納品分)

※期間中でも予定数に達した場合はキャンペーンを終了させていただきます。あらかじめご了承ください。

■NVIDIA H100 NVL搭載対応モデル例

・H100 NVL4基搭載 第4世代EPYC 1CPU 2Uサーバー

・H100 NVL8基搭載 第4世代EPYC 2CPU 4Uサーバー

・H100 NVL4基搭載 Intel Xeon 2CPU ワークステーション

NVIDIA H100 NVL性能

| NVIDIA H100 NVL | |

|

|

| GPUアーキテクチャ | NVIDIA Hopperアーキテクチャ |

| FP64 | 68 TFLOPS |

| FP64 Tensor コア | 134 TFLOPS |

| FP32 | 134 TFLOPS |

| TF32 Tensor コア | 1979 TFLOPS* |

| BFLOAT16 Tensor コア | 3958 TFLOPS* |

| FP16 Tensor コア | 3958 TFLOPS* |

| FP8 Tensor コア | 7916 TFLOPS* |

| INT8 Tensor コア | 7916 TFLOPS* |

| GPUメモリ | 188 GB |

| GPUメモリ帯域幅 | 7.8TB/秒 |

| デコーダー | 14 NVDEC 14 JPEG |

| 最大熱設計電力 (TDP) | 2x 350-400W (構成可能) |

| マルチインスタンス GPU | 各12GBの最大14のMIG |

| フォーム ファクター | 2x PCIe デュアルスロット空冷 |

| 相互接続 | NVLink: 600GB/秒 PCIe Gen5: 128GB/秒 |

| NVIDIA AI Enterprise | 含む |

*With sparsity.

※記載されている会社名、製品名は各社の商標または登録商標です。

■お申込み方法

下記のお問い合わせボタンより、

フォームまたはメールにて「H100 NVLアカデミックキャンペーン申込」とご記入のうえお申込みください。

折り返し担当者よりご連絡をさせていただきます。