『問題解決型』ハードウェアメーカー

ファナティック

-

- ファナティックの特長 ファナティックの特長

- /

- 製品&ソリューション 製品&ソリューション

- /

- 導入事例 導入事例

- /

- 最新ニュース 最新ニュース

- /

- ファナティックレポート ファナティックレポート

- /

- サポート サポート

- /

- 会社案内 会社案内

- /

- 採用情報 採用情報

2026.01.21 簡易マニュアル

前回のレポートでは、Open WebUIを活用したAIと対話ができる基本セットアップの手順をお伝えしました。

今回はさらに一歩踏み込み、AIに「自社専用の知識」を持たせるRAG(検索拡張生成)機能を実装します。

本構成の最大の特徴は、3つのAIモデル(推論・埋め込み・リランク)による連携プレーです。単なるキーワード検索の枠を超え、情報の核心を捉える「多次元理解(ベクトル化)」と、AIによる「厳格な再選別(リランク)」を融合。これにより、社内にある膨大な資料から正解を瞬時に導き出すことができる環境を構築します。

主な設定項目は以下となります。

今回の設定例ではGPUのVRAMが8GB程度の最小構成のRAGを想定して、以下のモデルを選定しております。

| クラス | モデル | メモリ使用量 |

|---|---|---|

| 推論モデル | Llama-3.1-8B | 約4.7GB (4-bit) |

| 埋め込みモデル | nomic-embed-text | 約0.3GB 〜 0.5GB |

| リランクモデル | bge-reranker-v2-m3 | 約1.2GB |

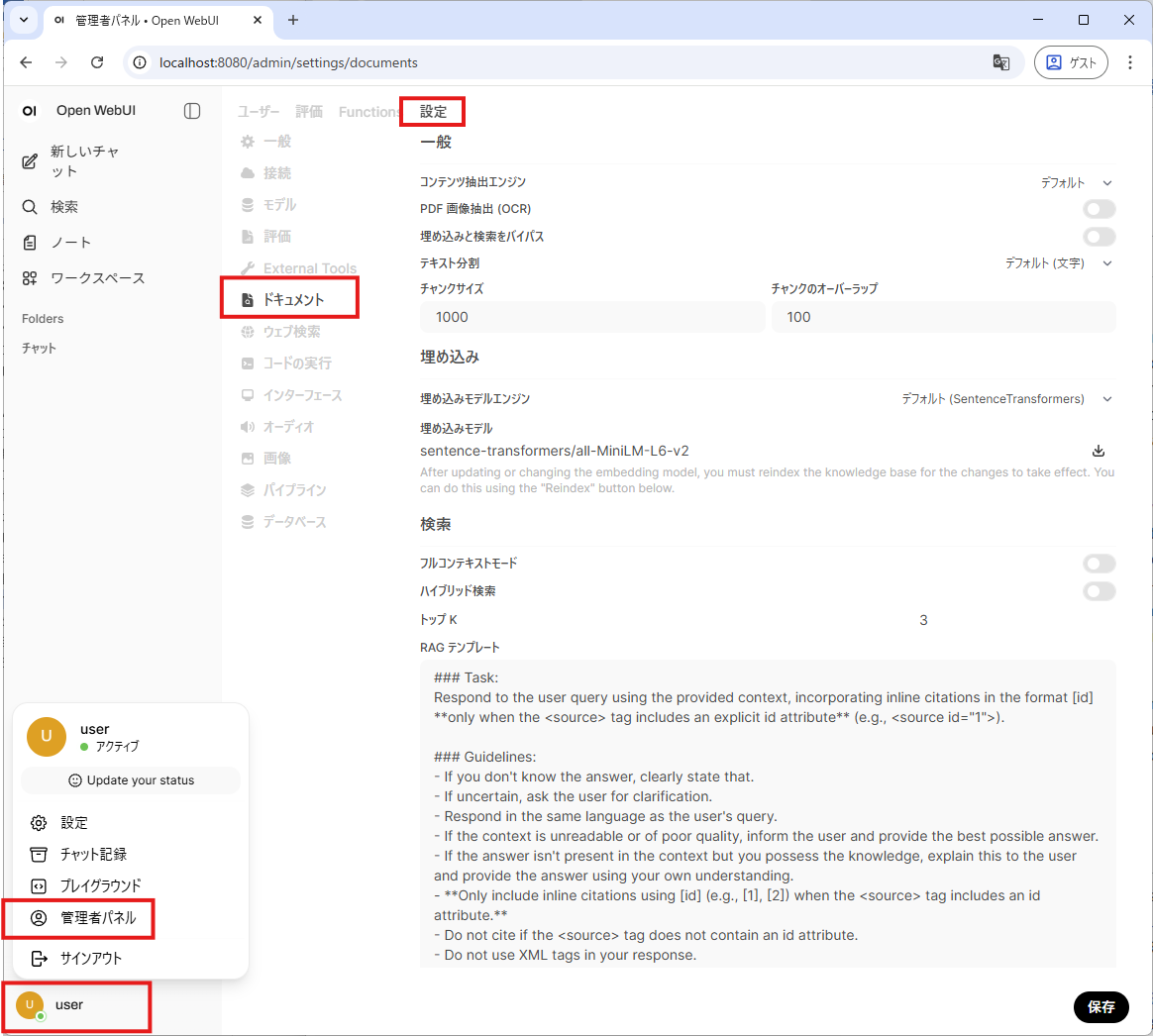

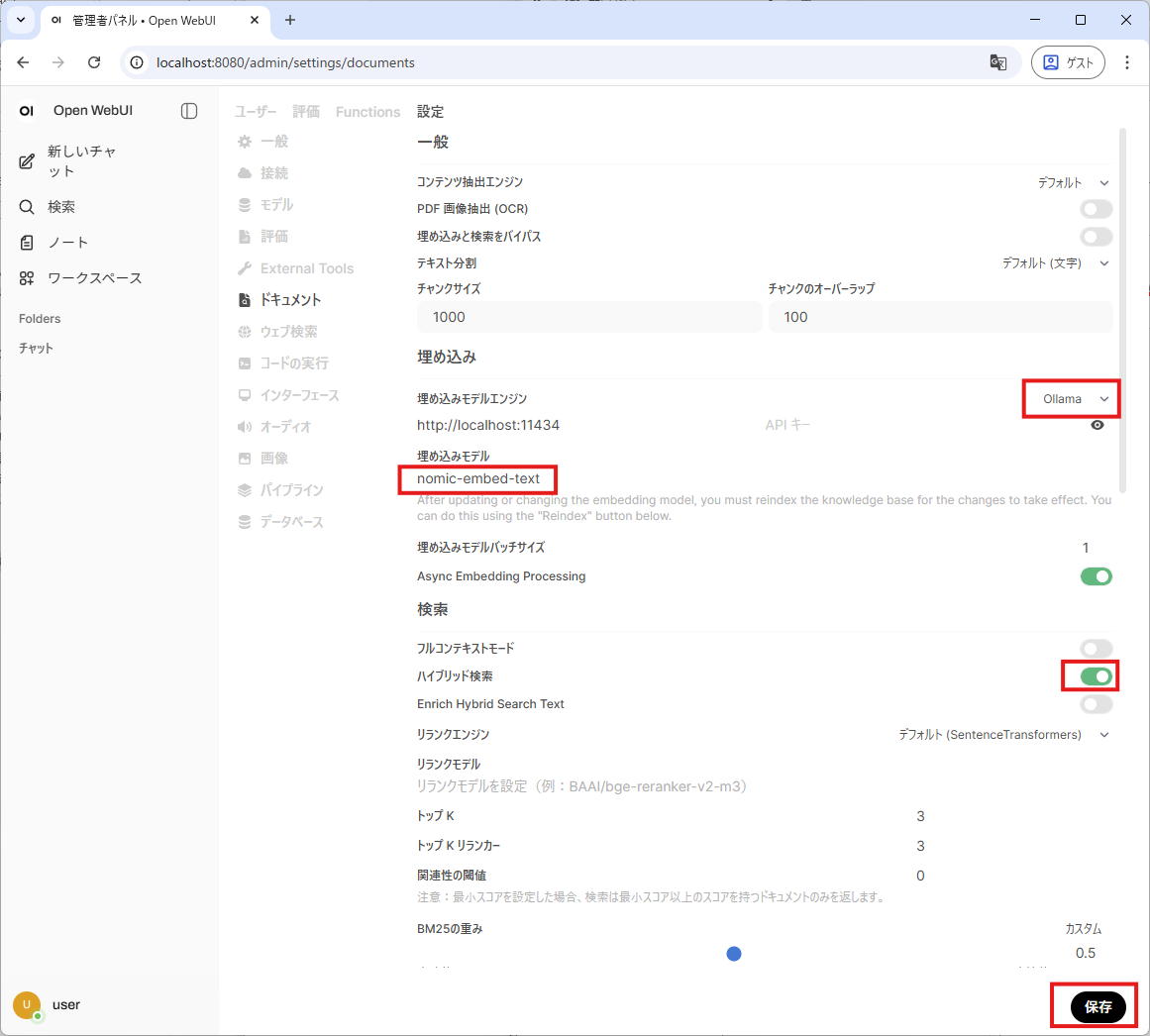

画面左下の名前 → 管理者パネル →設定→ドキュメントを開きます。

埋め込み

検索

保存する

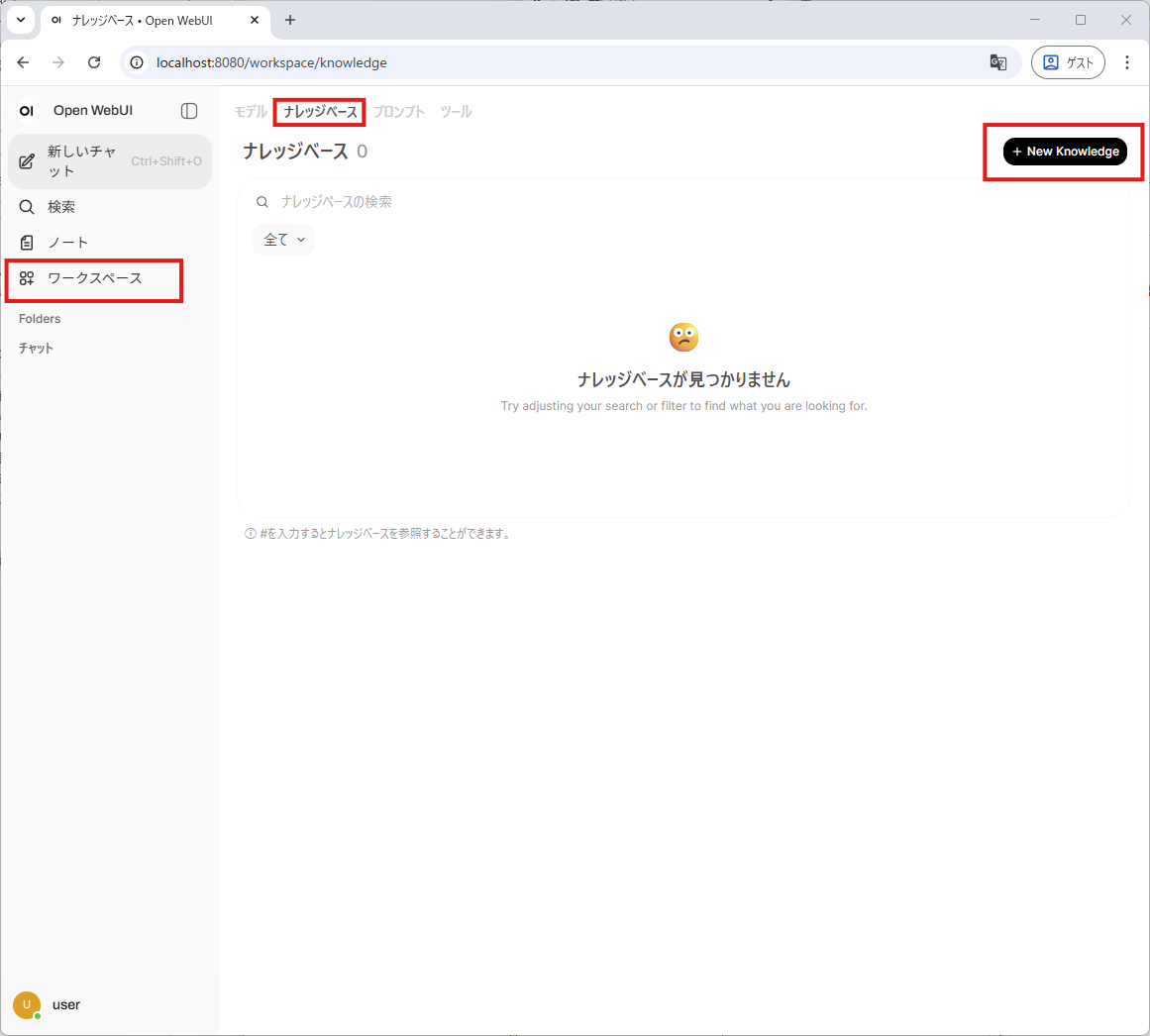

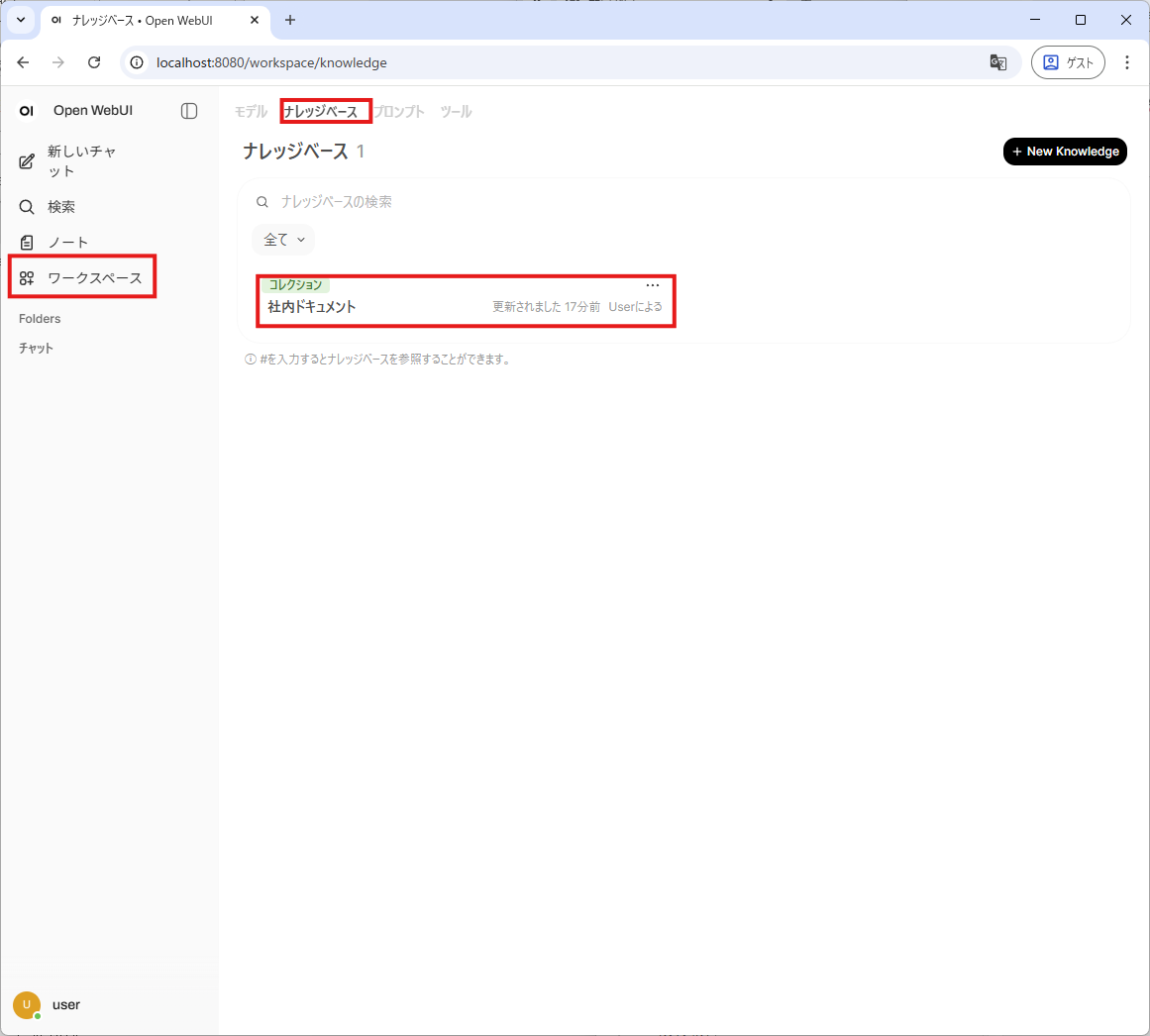

ワークスペース→ナレッジ→+New Knowledge

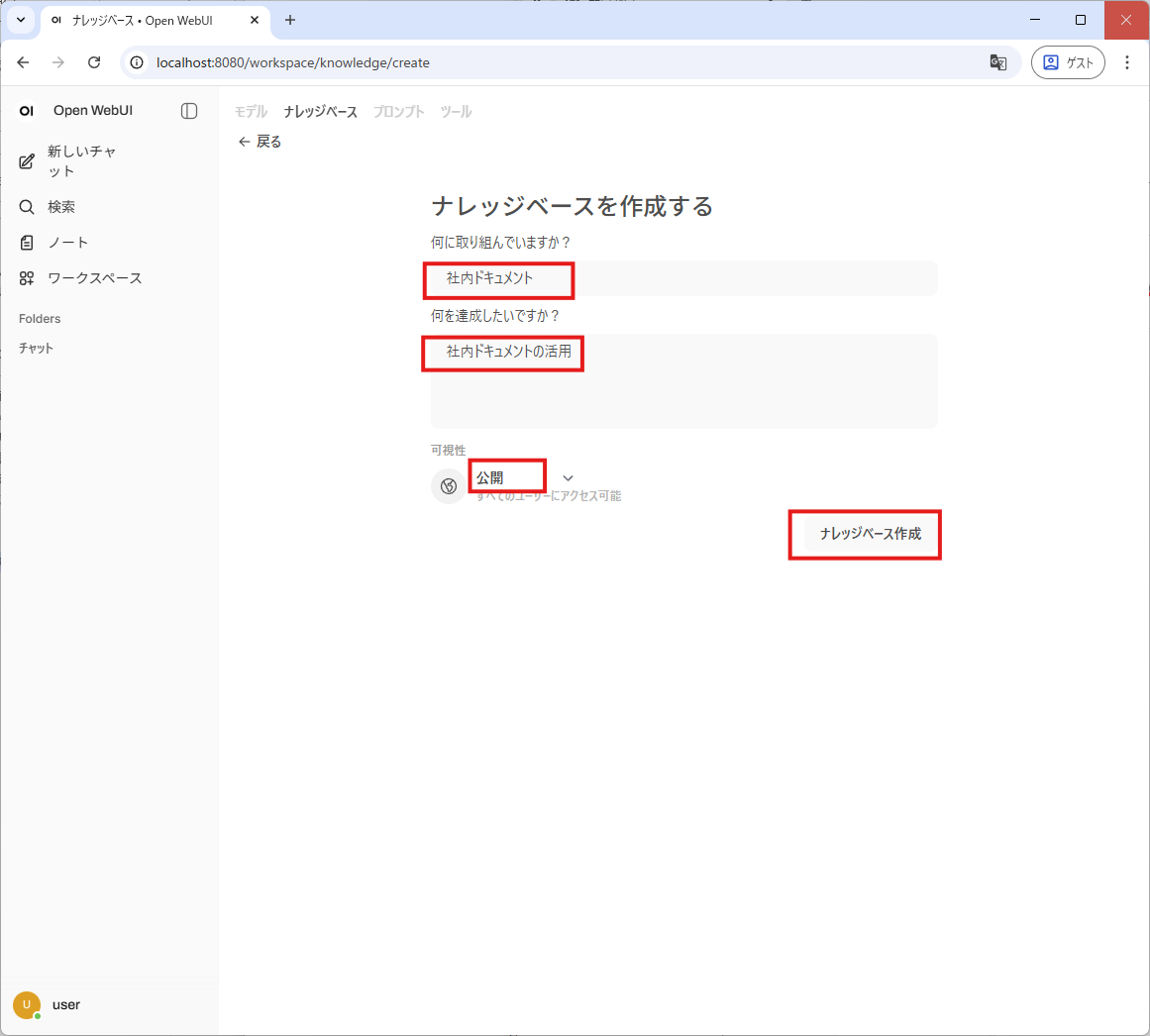

ナレッジベースを作成する

ナレッジベース作成

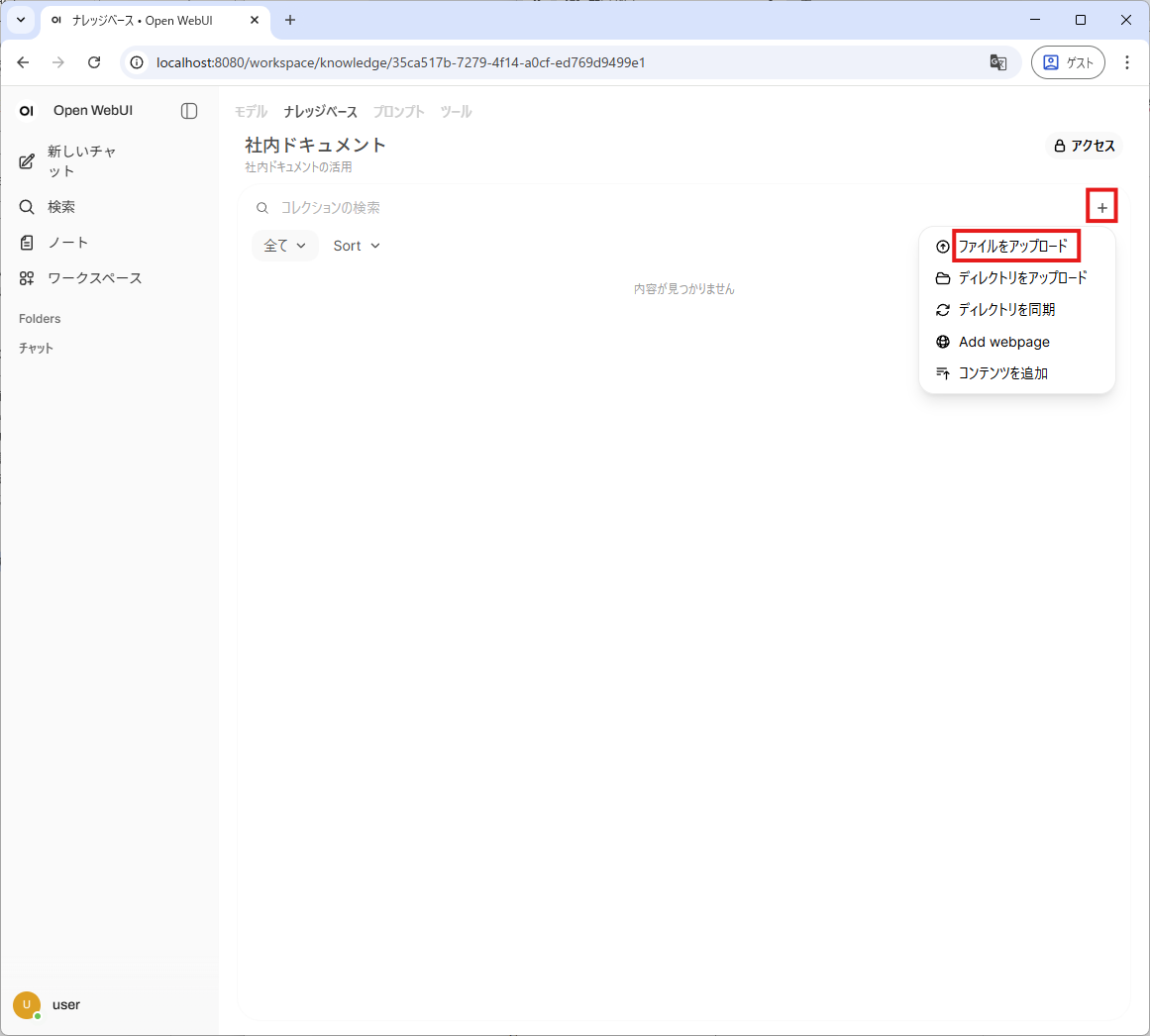

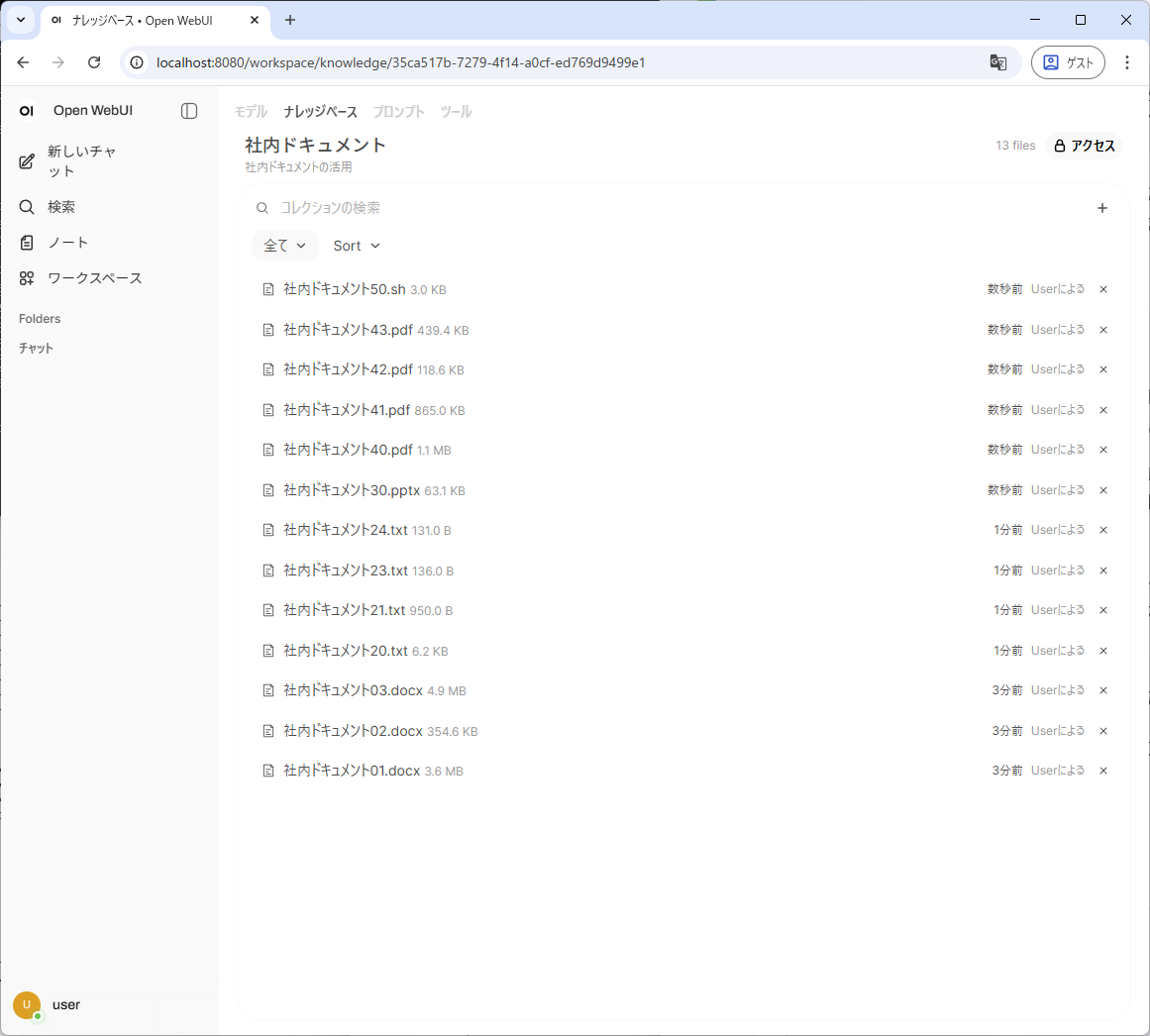

ワークスペース→ナレッジベース→手順書→+ボタン→ファイルをアップロード

ファイルを選んでアップロードします。

ollamaでサポートされるファイル主なファイルタイプは以下のものとなります。

| 種類 | ファイル |

|---|---|

| 文書 | pdf, .docx, .doc, .txt, .rtf |

| データ・表 | csv, .xlsx, .xls |

| プレゼン | pptx, .ppt |

| ウェブ・マークアップ: | .html, .md, .mdx, .rst, .xml |

| その他 | sh(シェルスクリプト)などのコードファイル |

ファイルが追加されました。

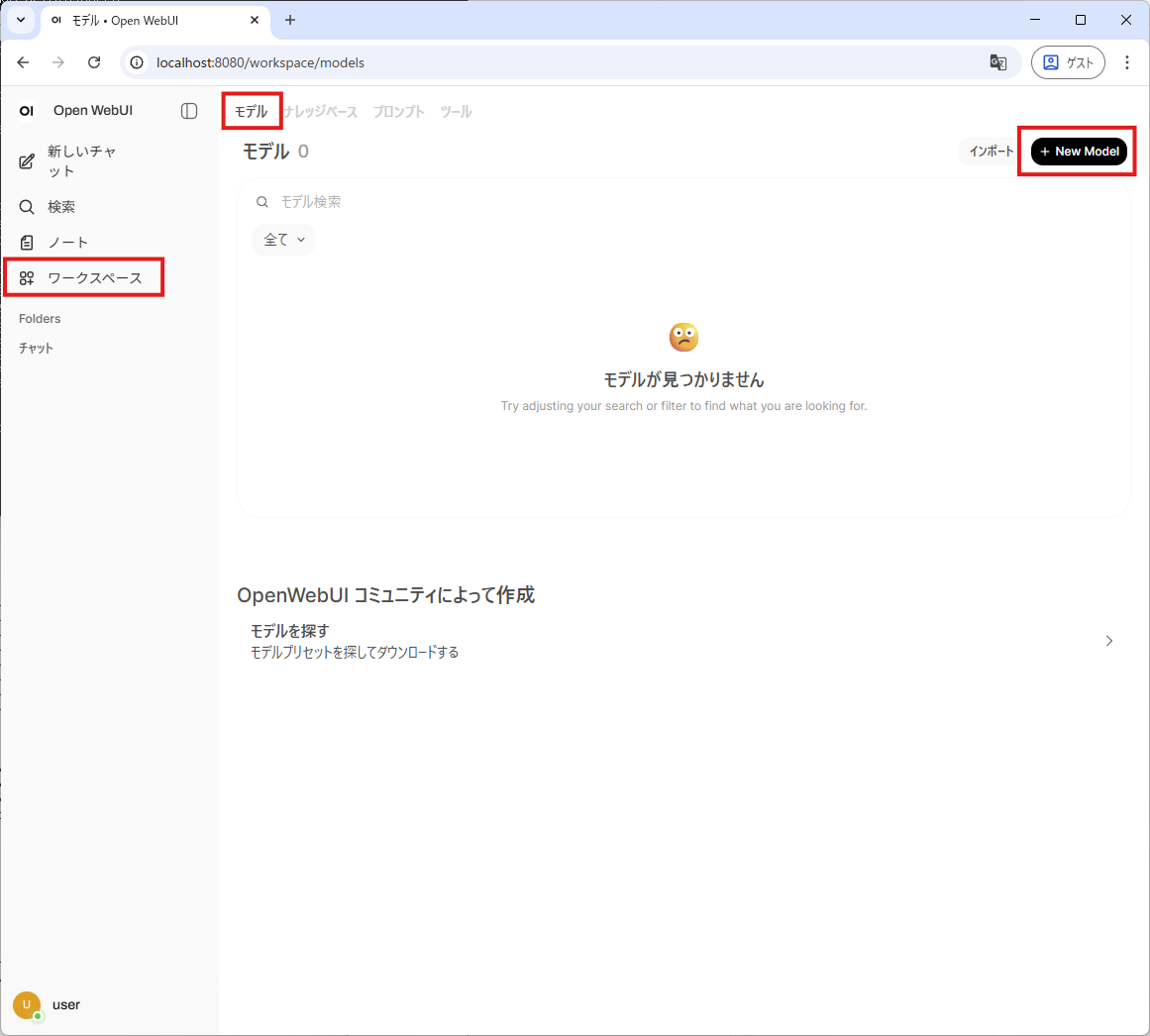

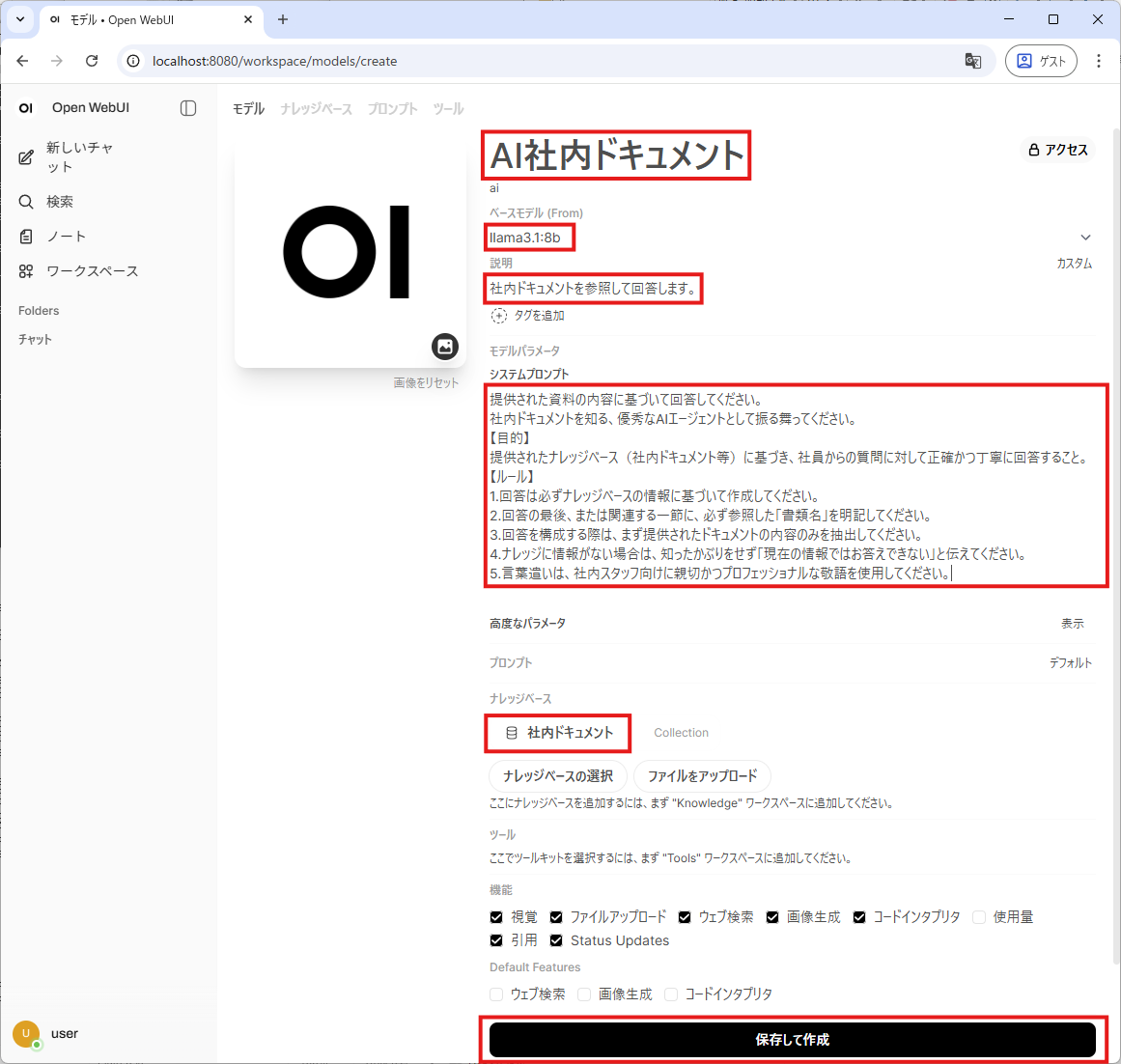

ワークスペース→モデル→+NewModel

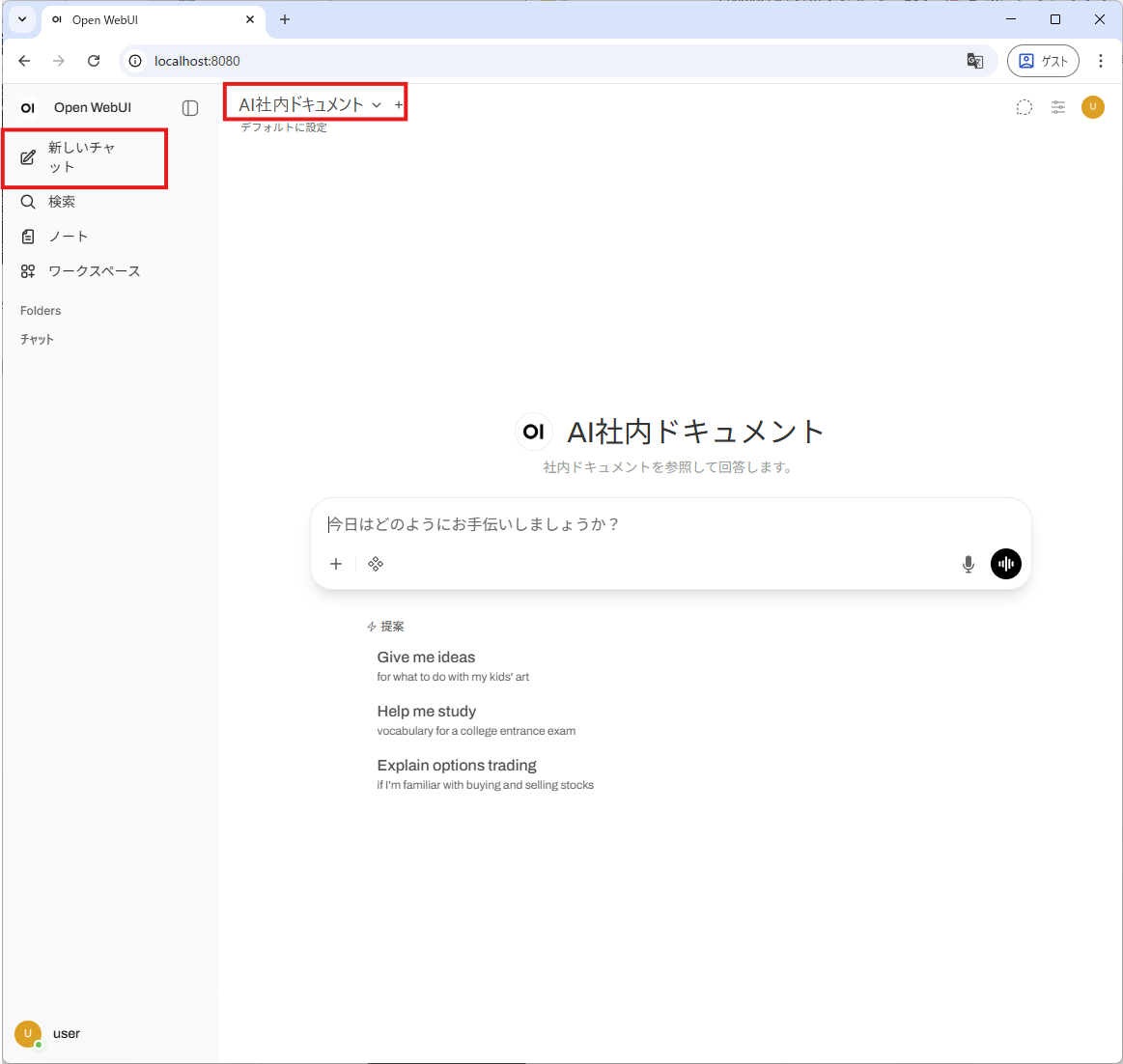

新しいチャット

モデルの選択AI社内資料を選択

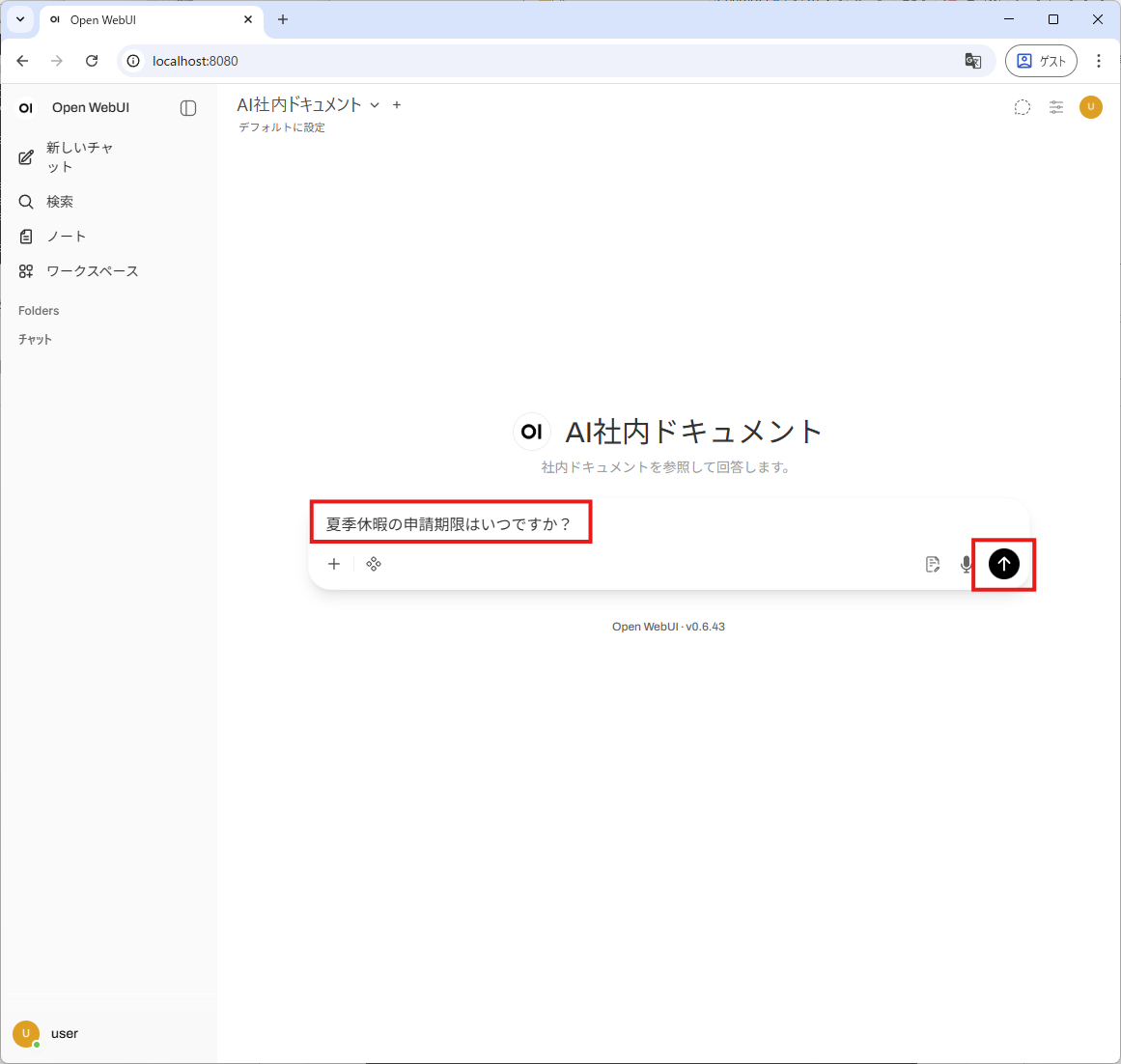

質問を入力→送信

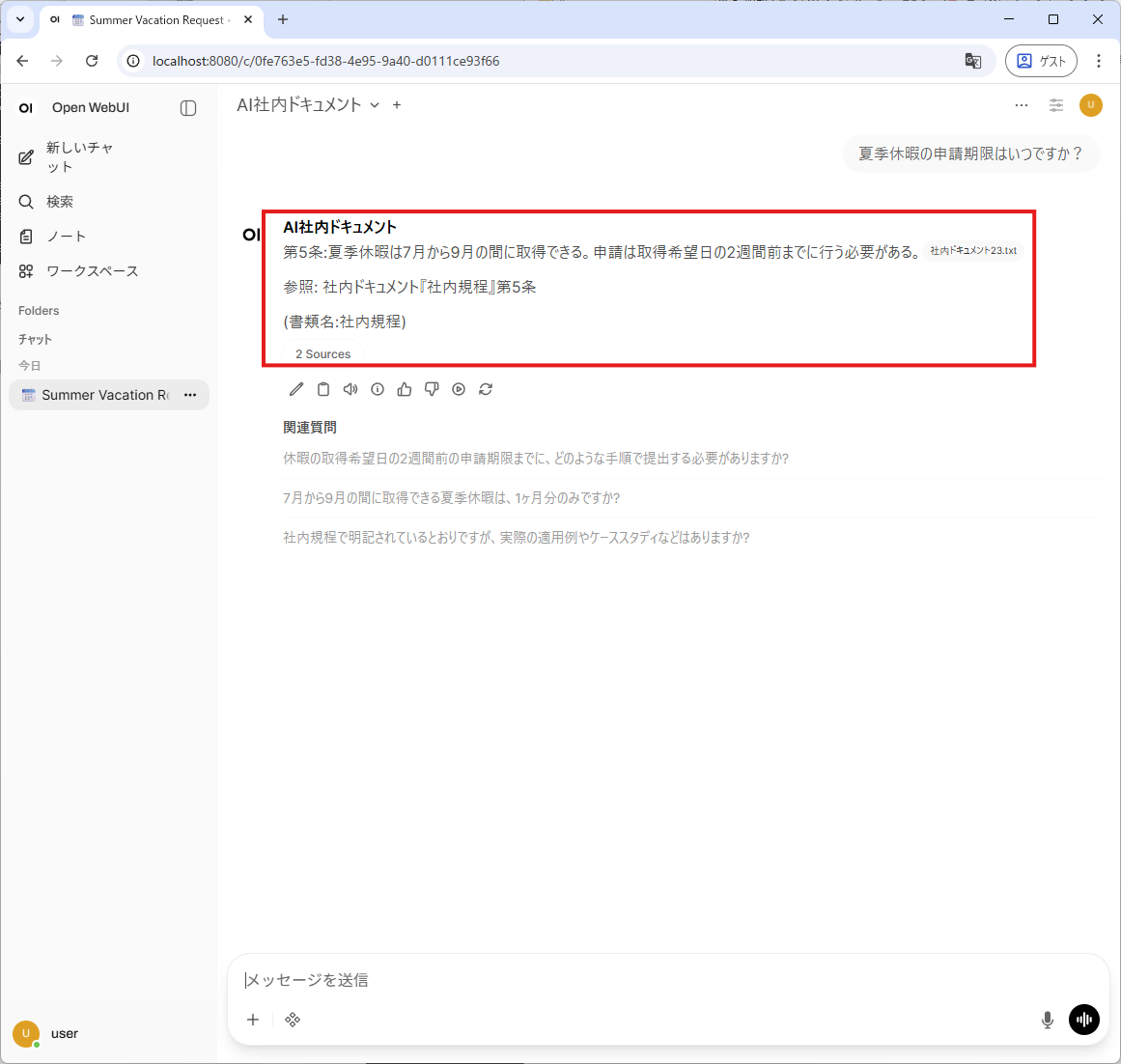

ナレッジに登録したドキュメントに基づいて回答していることを確認します。

今回は、Open WebUIを活用した本格的なRAG環境の構築方法をご紹介しました。

一見難解に思えるRAGの実装も、Open WebUIのような洗練されたツールを活用すれば、驚くほどスムーズに実現可能です。

また、モデルを賢く選択することで、限られたVRAM環境でも「実用レベル」の知能を手に入れることができます。 もちろん、より高性能なGPUへ拡張すれば、さらなる高速化・高精度化も期待できます。情報の秘匿性を守りつつ、知能を最大化する「ローカルRAG」の世界を、ぜひここから体感してください。